GenAI และ LLMs กับกระบวนการทำวิจัยทางเศรษฐศาสตร์

excerpt

ในช่วงไม่กี่ปีที่ผ่านมา มีการพูดถึง Generative AI (GenAI) และ Large Language Models (LLMs) กันมากขึ้น ในวงการวิชาการทางเศรษฐศาสตร์หรือธนาคารกลาง ก็มีการนำ GenAI เข้ามาใช้ในกระบวนการทำงานมากขึ้น บทความนี้เล่าถึงว่านักเศรษฐศาสตร์ใช้ประโยชน์อะไรจาก GenAI และ LLMs ในกระบวนการทำวิจัยกันบ้างและมีข้อควรระวังอย่างไร

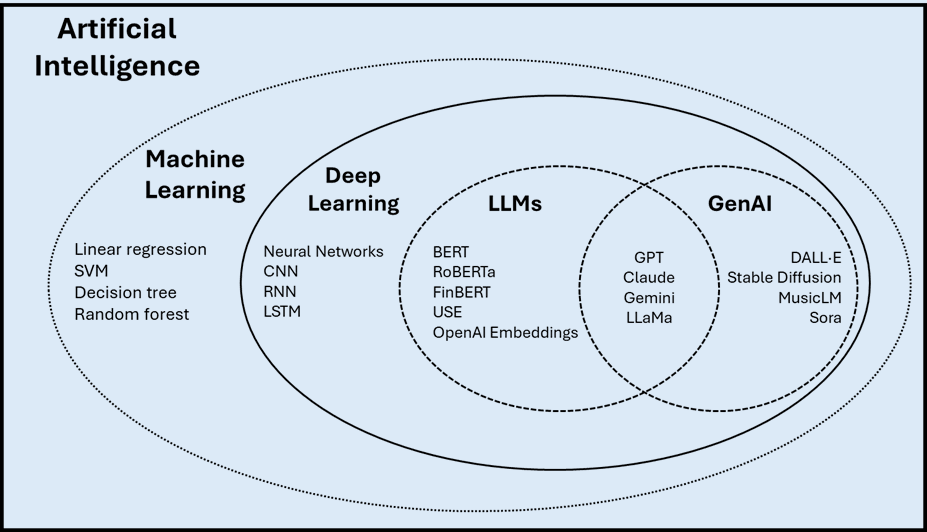

GenAI เป็นการประยุกต์ใช้เทคนิค Machine Learning (ML) โดยเฉพาะ Deep Learning ที่ถูกพัฒนาต่อยอดมาจนสามารถเข้าใจและตอบโต้ภาษามนุษย์ได้ หากย้อนกลับไปเมื่อ 10 กว่าปีที่แล้ว นักเศรษฐศาสตร์เริ่มพูดถึง ML กันมากขึ้น แต่เป็นในมิติที่ว่าเทคนิคทาง ML เช่น Random Forest หรือ Support Vector Machine ดีกว่าแบบจำลองทางเศรษฐมิติที่นักเศรษฐศาสตร์ใช้กันอยู่หรือไม่ อย่างไร (Varian, 2014; Mullainathan & Spiess, 2017) ข้อสรุปส่วนใหญ่เป็นว่า ML และเศรษฐมิติ เก่งคนละอย่างกัน สิ่งที่ ML เก่งกว่าชัดเจน คือ กรณีที่เราต้องการการพยากรณ์ที่แม่นยำ แต่ไม่ได้สนใจว่าปัจจัยอะไรเป็นปัจจัยหลักที่ส่งผลดังกล่าว (prediction problem) แต่สิ่งที่แบบจำลองทางเศรษฐมิติยังทำได้ดีกว่า คือ causal inference หรือการเข้าใจว่าปัจจัยบางอย่าง เช่น การขึ้นภาษี หรือการให้เงินช่วยเหลือ ส่งผลต่อผลลัพธ์ทางพฤติกรรมหรือเศรษฐกิจอย่างไร งานในช่วงถัดมา เช่น causal forest ได้พยายามดึงข้อดีของ ML กับเศรษฐมิติมารวมกัน ผู้ที่สนใจสามารถอ่านเพิ่มเติมได้ใน Athey & Imbens (2019)

งาน ML ในช่วงดังกล่าวยังเป็นการทำงานกับข้อมูลที่ถูกแปลงให้อยู่ในรูปตัวแปรต่าง ๆ แล้ว แต่ GenAI ที่เราจะกล่าวถึงในบทความนี้ มีความสามารถช่วยนักวิจัยแปลงข้อมูลดิบที่เป็นตัวอักษร รูปภาพและเสียงเป็นตัวแปรได้ด้วย รวมถึงสามารถวิเคราะห์ สรุปเนื้อความและโต้ตอบกับมนุษย์ได้

GenAI และ LLMs ถูกพัฒนาบนเทคนิค Deep Learning (DL) ซึ่งเป็นการใช้โครงข่ายประสาทเทียม (neural networks) หลายชั้นเพื่อเรียนรู้การแปลงข้อมูลดิบที่ซับซ้อน โดยไม่ต้องพึ่งการออกแบบตัวแปร1 ภายในกลุ่ม DL นี้ หนึ่งในสถาปัตยกรรมที่สำคัญ คือ Transformer ซึ่งมีกลไก attention ที่ช่วยให้แบบจำลองให้ความสนใจกับบริบทที่สำคัญของข้อมูลเป็นพิเศษมากกว่าที่จะให้ความสำคัญกับปริมาณหรือความถี่

LLMs เป็นหนึ่งในตัวอย่างของแบบจำลองที่อาศัย Transformer และถูกฝึกด้วยฐานข้อมูลข้อความขนาดใหญ่และหลากหลาย ไม่ว่าจะเป็นหนังสือ websites บทความและ codes โดยมีจุดมุ่งหมายให้แบบจำลองเรียนรู้และเข้าใจความสัมพันธ์และโครงสร้างของภาษา โดยแบบจำลอง LLMs เช่น BERT, RoBERTa เป็นโมเดล encoder ที่เปลี่ยนข้อความ input ให้เป็น vectors เชิงบริบท ที่ประกอบด้วยตัวเลข โดยมีการกำหนด format ไว้ล่วงหน้า และ vectors เหล่านี้ยังรักษาความหมายของข้อความไว้ได้ (encoding)

ส่วน GenAI คือ กลุ่มของแบบจำลอง DL ที่ถูกออกแบบมาเพื่อ “สร้างเนื้อหาใหม่” ไม่ว่าจะเป็นข้อความ ภาพ เสียง วิดีโอ หรือโค้ด ไม่ได้จำกัดเฉพาะการประมวลผลภาษา หลาย ๆ แบบจำลองที่ใช้กันอยู่แพร่หลาย เช่น GPT, Claude, LLaMA, Gemini มีการประยุกต์ใช้ทั้ง GenAI และ LLMs ในตัวแบบจำลองเพราะมีความสามารถทั้งในการเข้าใจภาษาธรรมชาติของ LLMs และการสร้างข้อความใหม่ได้อย่างต่อเนื่อง อย่างไรก็ดี GenAI ที่ไม่ได้เป็น LLMs ก็มีอยู่หลายรูปแบบเช่นกัน เช่น การสร้างภาพจากข้อความ (diffusion models เช่น Stable Diffusion, DALL·E), สร้างเพลง (Suno, MusicLM), หรือสร้างวิดีโอจากข้อความ (Sora, Runway Gen-2)2 ดังแสดงในรูปที่ 1

ในส่วนต่อ ๆ ไป หากเราเรียกกล่าวถึง GenAI ในหลาย ๆ บริบทมักจะหมายรวมถึงการอาศัย LLMs และ Deep Learning อยู่ด้วย โดยเราจะขอเล่าถึงบทบาทของ GenAI ที่สำคัญในกระบวนการทำวิจัยทางเศรษฐศาสตร์ ซึ่งคงเป็นเพียงตัวอย่างที่น่าสนใจเท่านั้น แต่ไม่ได้ครอบคลุมการนำ GenAI และ LLMs มาใช้ในงานทางเศรษฐศาสตร์ทั้งหมด

GenAI สามารถเป็นผู้ช่วยในขั้นตอนการทบทวนวรรณกรรมและหาข้อมูลได้ค่อนข้างดี ตัวอย่างเช่น หากเราถามว่าบทความเกี่ยวการใช้ GenAI ในการทำวิจัยทางเศรษฐศาสตร์ที่ได้รับการตีพิมพ์ในวารสารชั้นนำทางเศรษฐศาสตร์มีอะไรบ้าง GenAI ก็สามารถให้คำตอบตามรูปที่ 2

Can you find articles discussing GenAI, LLMs or Deep Learning for economic research published in top economic journals?

Absolutely—here’s a tight, high-signal reading list from top economics journals that directly discuss or operationalize Generative AI / LLMs / Deep Learning for economic research (methods, measurement, or applied evidence). I’ve grouped them by “methods & surveys” vs. “applications/evidence.”

Methods & surveys (how economists can use LLMs / deep learning)

- Melissa Dell (2025), “Deep Learning for Economists,” Journal of Economic Literature. A field guide to deep neural nets for econ applications (classification, embeddings, gen-AI, record linkage, large text/image corpora) with a living companion site (EconDL). Great starting point if you want code-adjacent intuition + scalable workflows.

- Anton Korinek (2023), “Generative AI for Economic Research,” Journal of Economic Literature. Practical playbook for using LLMs across the research stack (ideation → coding → math derivations), with regularly updated AEA supplements on agentic workflows.

- Ingar Haaland, Christopher Roth, Stefanie Stantcheva, Johannes Wohlfart (forthcoming, 2025), “Understanding Economic Behavior Using Open-Ended Survey Data,” Journal of Economic Literature. Survey of methods for LLM-based elicitation/annotation of open-ended responses (including voice/AI interviews) and how to validate them.

- Matthew Gentzkow, Bryan Kelly, Matt Taddy (2019), “Text as Data,” Journal of Economic Literature. Pre-GenAI foundation that still underpins today’s LLM text work (measurement design, validation, pitfalls).

- Sendhil Mullainathan, Jann Spiess (2017), “Machine Learning: An Applied Econometric Approach,” Journal of Economic Perspectives. Core ML-vs-econometrics framing that helps decide when prediction-first tools (incl. deep learning) fit your question.

Applications & evidence in top journals

- Erik Brynjolfsson, Danielle Li, Lindsey Raymond (2025), “Generative AI at Work,” Quarterly Journal of Economics. Large-scale field experiment of LLM-based assistance for customer support; big productivity and quality gains—useful template for measuring GenAI impacts.

- Johannes A. Bohren, Alex Imas, Michael Powell (2025), “Systemic Discrimination: Theory and Measurement,” Quarterly Journal of Economics. Uses an LLM to generate standardized recommendation letters within an identification framework—nice example of embedding LLMs inside an econ measurement design.

- Thomas Graeber, Christopher Roth (2024), “Stories, Statistics, and Memory,” Quarterly Journal of Economics. Employs modern embedding/language-model tooling to analyze narratives and memory—good for seeing state-of-the-art text similarity in an econ setting.

Short, citable AEA pieces (useful but briefer than full articles)

- Benjamin Labaschin, Tyna Eloundou, Sam Manning, Pamela Mishkin, Daniel Rock (2025), “Extending ‘GPTs Are GPTs’ to Firms,” AEA Papers & Proceedings. Builds firm-level exposure to LLMs from occupation mixes—handy for exposure/impact work at the firm margin.

If you’d like, I can turn this into a BibTeX/CSV with abstracts and quick one-line “when to cite this” notes, or expand to near-top outlets (e.g., AER: Insights, AEJs) and top-finance journals using LLMs/deep learning (e.g., RFS).

คำตอบข้างต้น แสดงว่า GenAI พอจะวิเคราะห์ได้ว่าวารสารชั้นนำทางเศรษฐศาสตร์ คือ อะไร สรุปบทความได้ รวมถึงมีการตอบสิ่งที่คาดว่าผู้ใช้น่าจะอยากรู้ แม้จะไม่ได้ถามตรง ๆ เช่น การยกตัวอย่างงานเชิงประยุกต์ที่ตีพิมพ์ใน Quarterly Journal of Economics ในปี 2025 มาด้วย แม้คำตอบดังกล่าวอาจจะยังไม่ได้ครอบคลุมวรรณกรรมทั้งหมด เช่น ไม่ได้อิงถึง Korinek (2024) ซึ่งเป็นฉบับล่าสุดโดยตรง แต่ก็น่าจะเป็นการเริ่มต้นที่ดีให้กับนักวิจัยได้

นอกจากนี้ Korinek (2024) ยังเล่าถึงการใช้ GenAI เพื่อระดมความคิด ปรับปรุงโจทย์วิจัยให้ชัดเจนขึ้น หรือช่วยหาข้อโต้แย้ง อย่างไรก็ดี นักวิจัยควรระวังในเรื่อง hallucination ซึ่งหมายถึง การที่แบบจำลองแต่งคำตอบที่ไม่มีจริงขึ้นมาเอง เช่น อาจจะให้ชื่อบทความที่ถูกต้อง แต่ให้ข้อมูลรายละเอียดการตีพิมพ์ที่ผิด แม้ดูเผิน ๆ อาจจะถูกเพราะเป็นวารสารที่มีอยู่จริงและดูน่าจะเกี่ยวข้องกับชื่อบทความ (ตัวอย่าง Chat21 ใน Korinek, 2024)

ข้อมูลเป็นส่วนสำคัญของงานวิจัย ในอดีตข้อมูลที่จะสามารถนำมาวิเคราะห์ได้มักจะต้องถูกจัดเก็บในรูปแบบที่มีโครงสร้าง (structured data) เช่น เป็นตาราง, XML (eXtensible Markup Language), CSV (comma-separated values) แต่ในปัจจุบัน เทคโนโลยีสามารถช่วยแปลงข้อมูลดิบและไร้โครงสร้าง (unstructured data) ให้เป็น structured data เพื่อนำไปใช้ในการวิเคราะห์ต่อได้

เราขอยกตัวอย่างงานสองกลุ่ม คือ กลุ่มที่ใช้ GenAI มาจำแนกประเภทหรือสกัดข้อมูลจากข้อความจำนวนมาก เช่น บทสนทนาใน social media รายงานการประชุม และกลุ่มที่ใช้ GenAI มาแปลงข้อมูลรูปภาพ เช่น ภาพถ่ายดาวเทียม รูปภาพ เอกสารที่มาจากการสแกน ข้อมูลเหล่านี้ล้วนมีศักยภาพในการนำมาศึกษาเรื่องต่าง ๆ

งานด้านนี้เริ่มพัฒนามาจากงานด้าน Natural Language Processing (NLP) ซึ่งเริ่มตั้งแต่การนับคำ เช่น bag-of-words และ TF-IDF รวมถึงการดูรูปแบบประโยค โดยที่แบบจำลองยังไม่สามารถเรียนรู้ความหมายในบริบทได้ จนกระทั่งพัฒนามาสู่ LLMs ที่เข้าใจบริบทที่ซับซ้อนมากขึ้น ในปัจจุบัน LLMs ได้ถูกนำมาใช้สกัดความรู้สึกหรือทัศนคติจากเอกสารต่าง ๆ (sentiment analysis) จัดหมวดหมู่หรือจำแนกประเภท (classification) เพื่อสร้างตัวแปรที่นักวิจัยสนใจ โดยเราขอเล่าถึงงานกลุ่มนี้ที่น่าสนใจบางงาน

sentiment analysis มักถูกใช้เพื่อวิเคราะห์ถ้อยแถลงของธนาคารกลางว่าภาพรวมของเศรษฐกิจเป็นบวกหรือลบ เพื่อคาดการณ์ว่าธนาคารกลางมีแนวโน้มที่ดำเนินนโยบายการเงินที่เข้มงวดหรือผ่อนคลายในอนาคต หรือเพื่อสกัดหัวข้อที่สนใจ เช่น เงินเฟ้อ การจ้างงาน Pfeifer & Marohl (2023) ได้พัฒนา CentralBankRoBERTa จากฐานข้อมูลถ้อยแถลงของธนาคารกลางที่เป็นภาษาอังกฤษเพื่อแยกกลุ่มผู้ที่มีส่วนเกี่ยวข้องในถ้อยแถลงว่าเป็นการพูดถึงรัฐบาล ธนาคารกลาง ภาคประชาชน ธุรกิจ หรือสถาบันการเงิน Silva et al. (2025) ใช้ LLMs (fine-tuned multilingual LLM) มาศึกษาเอกสารของธนาคารกลางกว่า 74,000 ชิ้น โดยรวบรวมมาจากธนาคารกลาง 169 แห่ง ตั้งแต่ปี 1884-2025 และพบว่าการสื่อสารของธนาคารกลางมีการเปลี่ยนแปลงจากอดีตที่มักจะเป็นการอธิบายนโยบายช่วงที่ผ่านมาเกี่ยวกับอัตราแลกเปลี่ยนเป็นการมองไปในอนาคตมากขึ้น ไม่ว่าจะเป็นเรื่องของอัตราเงินเฟ้อหรืออัตราดอกเบี้ย

นอกจากเรื่องการสื่อสารของธนาคารกลาง ยังมีแบบจำลองที่ถูกฝึกมาสำหรับสกัดหัวข้อหรือความรู้สึกแต่ละบริบทโดยเฉพาะ เช่น FinBERT สำหรับจากข่าวหรือบทสนทนาเกี่ยวกับการเงินและ ClimateBERT สำหรับบริบทเกี่ยวกับ climate change

ในด้าน classification GenAI ถูกนำมาใช้สร้างตัวแปรที่นักเศรษฐศาสตร์สนใจมากขึ้น เช่น Eloundou et al. (2024) ลองใช้คนและ GPT-4 จำแนกประเภทกิจกรรมการทำงานเพื่อศึกษาว่างานลักษณะใดมีความเสี่ยงในการถูกแทนที่ด้วย AI จากฐานข้อมูล Occupational Information Network (ONET) ของสหรัฐอเมริกา (อาชีพเกือบ 1,000 อาชีพ และงานเกือบ 20,000 ประเภท)3 และพบว่าคำตอบจากคนและ GPT-4 ค่อนข้างไปด้วยกัน และราว 46% ของอาชีพต่างทั้งหมดมีงานอย่างน้อยครึ่งหนึ่งที่ GenAI สามารถเข้ามามีบทบาทได้ ขณะที่ Kazinnik & Brynjolfsson (2025) ศึกษาเฉพาะตำแหน่งงานใน Federal Reserve Banks และก็พบว่างานครึ่งหนึ่ง GenAI สามารถเข้ามามีบทบาทได้ แต่ประมาณครึ่งหนึ่งของตำแหน่งงานยังต้องอาศัยการสื่อสาร ปฏิสัมพันธ์กับผู้อื่นและความเชี่ยวชาญเฉพาะทางสูง ซึ่ง AI ยังแทนที่ได้ยาก

ประเด็นสำคัญ คือ เราจะทราบได้อย่างไรว่า LLMs จำแนกข้อมูลได้ถูกต้อง Fang et al. (2025) ใช้ LLMs จำแนกเอกสารนโยบายของรัฐบาลจีนกว่า 3 ล้านฉบับ ก็มีความกังวลเรื่องนี้เพราะเอกสารแต่ละฉบับค่อนข้างยาวและคุณภาพคำตอบของ LLMs มักจะไม่ดีนักเมื่อต้องอ่านข้อความที่ยาวมาก ทีมวิจัยได้แก้ปัญหานี้โดยวิธีการ prompt แบบหลายขั้นตอน เช่น แยกเอกสารว่าเป็นนโยบายอุตสาหกรรมหรือไม่ สกัดอุตสาหกรรมเป้าหมาย และจำแนกรายละเอียดอื่น ๆ เช่น เครื่องมือที่ใช้ กฎเกณฑ์ต่าง ๆ ที่เกี่ยวข้อง พร้อมให้นิยามที่ชัดเจน ตั้งคำถามชี้นำ ให้ตัวอย่างโต้แย้ง ให้ LLMs ระบุคะแนนระดับความมั่นใจ และสุ่มตัวอย่างให้คนตรวจสอบ เพื่อปรับวิธี prompt อยู่หลายรอบ งานนี้ใช้ Gemini-1.5-flash เป็นหลัก พร้อมกับใช้ LLMs ขั้นสูงกว่า คือ Gemini-1.5-pro และ GPT4o-mini ซึ่งน่าจะมีมุมมองที่ต่างกันมาประเมินผลอีกรอบ

เอกสาร offline ในอดีตจำนวนมากถูกจัดเก็บไว้โดยการสแกน เทคโนโลยี Deep Learning ช่วยให้นักวิจัยสามารถแปลงข้อมูลมหาศาลเหล่านี้ให้สามารถนำมาใช้ได้ง่ายขึ้น โดยตัวอย่างการประยุกต์ใช้ Transformer ได้แก่ Optical Character Recognition (OCR) ที่นำมาสกัดตัวอักษรจากเอกสารสแกน และ Vision Transformer ที่ใช้ในการจำแนกรูปภาพ

บทความ American Stories (Dell et al., 2023) แปลงข้อมูลจากบทความในหนังสือพิมพ์เก่าที่ถูกสแกนเก็บไว้กว่า 20 ล้านฉบับในช่วงปี 1774-1963 ซึ่งมีคอลัมน์ย่อย ๆ รวมกันอีก 1.14 พันล้านคอลัมน์เป็นฐานข้อมูลใหม่ โดยสามารถแยกภาพเหล่านี้เป็นบทความได้ 438 ล้านบทความ และข้อมูลอื่นๆ อาทิ โฆษณา หรือผลการแข่งขันกีฬา และในแต่ละบทความมีการจำแนกรายละเอียดต่าง ๆ เช่น หัวข้อข่าว วันที่ สถานที่ ชื่อหนังสือพิมพ์ งานนี้ได้ออกแบบ workflow โดยแนะนำให้เริ่มจาก object/ layout detection ก่อน เพื่อดูว่าเอกสารแต่ละหน้ามีองค์ประกอบอะไรบ้าง แล้วค่อยส่งไป OCR ตามชนิดขององค์ประกอบ และมีการพัฒนา LayoutParser และ EfficientOCR ที่สามารถจัดการกับข้อมูลประเภทนี้ได้ดี ผู้ที่สนใจสามารถอ่านเพิ่มเติมได้ใน Dell (2025) และ EconDL blog ของ Dell

ฐานข้อมูลดังกล่าวช่วยให้นักวิจัยที่สนใจสามารถหาข่าวใหญ่ที่สุดในรอบปีได้อย่างรวดเร็ว รวมถึงสามารถศึกษาเกี่ยวกับการแพร่กระจายของข่าวทั้งข้ามสื่อและข้ามช่วงเวลา Franklin et al. (2024) ได้ใช้ฐานข้อมูลดังกล่าวและพัฒนาแบบจำลองที่ผู้ใช้สามารถใส่ข้อความข่าวในปัจจุบันแล้วดึงข่าวในอดีตที่มี “บริบท/แนวเรื่อง” ใกล้เคียงกันกลับมาได้ เพื่อช่วยในการศึกษาเศรษฐศาสตร์เชิงประวัติศาสตร์ โดยงานดังกล่าวต้องทำการปิดบังชื่อบุคคล หน่วยงาน สถานที่ ที่อยู่ในข่าว เพื่อให้แบบจำลองเรียนรู้เฉพาะบริบทของข่าวและสร้างความเชื่อมโยงได้

นอกจากนี้ GenAI ยังสามารถใช้สรุปเนื้อหาจากวิดีโอได้ Korinek (2024) ยกตัวอย่าง prompt ที่ให้ Google DeepMind’s Gemini สรุปเนื้อหาจากวิดีโอใน YouTube ซึ่ง Gemini ก็ทำได้ค่อนข้างดี ในงานทาง remote sensing ก็มีการใช้ Deep Learning เข้ามาวิเคราะห์มากขึ้นเช่นกัน เช่น d’Aspremont et al. (2024) ใช้ภาพถ่ายดาวเทียมในหลายประเทศเพื่อตรวจจับความร้อนที่แผ่ออกมาจากโรงงานผลิตซีเมนต์ เพื่อสร้างดัชนีชี้วัดกิจกรรมทางเศรษฐกิจในอุตสาหกรรมก่อสร้างแบบ real-time และพบว่าดัชนีดังกล่าววัดกิจกรรมการก่อสร้างได้ดีกว่าดัชนีดั้งเดิมที่สร้างจากข้อมูลใบอนุญาตหรือแบบสอบถามเกี่ยวกับคำสั่งซื้อหรือสินค้าคงคลัง โดย transformer models ที่ได้รับการฝึกมาเกี่ยวกับภูมิศาสตร์โดยเฉพาะสามารถแยกแยะภาพรูปแบบต่าง ๆ เช่น พื้นผิวอาคาร ลักษณะพืชผล ถนน/โครงข่าย และเงาได้ดี

GenAI สามารถช่วยงานด้าน coding และแก้โจทย์คณิตศาสตร์ได้ ผู้ใช้สามารถสั่งให้ LLMs เขียน แก้ไข หรือ อธิบายโค้ด ช่วยตรวจหาข้อผิดพลาด (debug) การแปลงโค้ดจากภาษาหนึ่งไปอีกภาษาหนึ่ง รวมถึงสามารถสร้างกราฟหรือสร้างสถิติต่าง ๆ เพิ่มเติมจากข้อมูลได้ ตัวอย่างในรูปที่ 3 เป็นการขอให้ ChatGPT เขียนภาษา python ในการ solve Ramsey growth model เมื่อใช้กับ Chat-GPT5 คำตอบนอกจากจะเป็นโค้ด python เต็มรูปแบบพร้อมลูปหา solution ยังมีคำอธิบายแต่ละขั้นตอนพร้อมทั้ง plot กราฟของ output พร้อมรันได้ทันที (รูปที่ 3)

Can you write python code to solve the Ramsey growth model for standard parameter values?

Here’s a clean, self-contained Python script that solves the (discrete-time) Ramsey–Cass–Koopmans model with CRRA utility and Cobb–Douglas production using a shooting method.

- Uses standard baseline parameters (you can tweak them).

- Computes the steady state analytically.

- Chooses the initial consumption by bisection so the path converges to the steady state capital.

- Simulates the transition path for , , , .

- Plots the results.

1"""2Ramsey–Cass–Koopmans (discrete time) with CRRA utility and Cobb–Douglas production.3

4Planner chooses {c_t} to maximize sum_{t=0..∞} β^t * u(c_t), u(c) = c^(1-θ)/(1-θ)5s.t. k_{t+1} = (1-δ) k_t + A k_t^α - c_t, c_t >= 0, k_t >= 06Euler: c_{t+1} = c_t * [ β * (1 - δ + α A k_{t+1}^{α-1}) ]^{1/θ}7

8We solve for a finite horizon T large enough and pick c0 by shooting (bisection)9so that k_T is close to the steady-state k*.10"""11

12import numpy as np13import matplotlib.pyplot as plt14

15# -----------------------------16# 1) Parameters (adjust as needed)17# -----------------------------18A = 1.0 # TFP19alpha = 0.33 # capital share20delta = 0.08 # depreciation21beta = 0.96 # discount factor22theta = 2.0 # CRRA coefficient (EIS = 1/theta)23

24T = 200 # simulation horizon (long enough to converge)25k0 = 0.8 # initial capital (try values below/above k*)26

27# -----------------------------28# 2) Steady state (analytical)29# -----------------------------30# In steady state: β * [1 - δ + α A k*^(α-1)] = 1 => α A k*^(α-1) = 1/β - (1 - δ)31rhs = 1.0/beta - (1.0 - delta)32if rhs <= 0:33 raise ValueError("No positive steady state: 1/β <= (1-δ). Check parameters.")34

35k_star = (rhs / (alpha * A)) ** (1.0 / (alpha - 1.0)) # note: α-1 < 036y_star = A * k_star**alpha37c_star = y_star - delta * k_star # since i* = δ k* in steady state38i_star = delta * k_star39

40# -----------------------------41# 3) Helpers: simulate path given c042# -----------------------------43def simulate_path(c0, T=T, k0=k0):44 """45 Given initial consumption c0, simulate {k_t, c_t} forward using:46 k_{t+1} = (1-δ)k_t + A k_t^α - c_t47 c_{t+1} = c_t * [ β (1 - δ + α A k_{t+1}^{α-1}) ]^{1/θ}48 Returns dict with paths and a flag for feasibility.49 """50 k_path = np.empty(T+1); k_path[:] = np.nan51 c_path = np.empty(T+1); c_path[:] = np.nan52

53 k_path[0] = k054 c_path[0] = c055

56 feasible = True57 for t in range(T):58 k_next = (1.0 - delta) * k_path[t] + A * (k_path[t]**alpha) - c_path[t]59 if (k_next <= 0) or (c_path[t] <= 0) or np.isnan(k_next):60 feasible = False61 break62 k_path[t+1] = k_next63

64 # Marginal product of capital next period:65 mpk_next = alpha * A * (k_path[t+1] ** (alpha - 1.0))66 growth_factor = beta * (1.0 - delta + mpk_next)67

68 if growth_factor <= 0:69 feasible = False70 break71

72 c_path[t+1] = c_path[t] * (growth_factor ** (1.0 / theta))73 if c_path[t+1] <= 0 or np.isnan(c_path[t+1]):74 feasible = False75 break76

77 # Build additional series if feasible78 out = {79 "feasible": feasible,80 "k": k_path,81 "c": c_path,82 }83 if feasible:84 y = A * (k_path**alpha)85 i = y - c_path86 out.update({"y": y, "i": i})87 return out88

89# -----------------------------90# 4) Shooting: choose c0 by bisection to hit k_T ≈ k*91# -----------------------------92# Upper/lower bounds for initial consumption:93# Lower bound close to 0, upper bound not exceeding output at t=0.94y0 = A * (k0**alpha)95c0_low = 1e-1096c0_high = max(1e-8, min(y0 + (1.0 - delta) * k0, y0)) # safe upper bound97

98target = k_star99tol = 1e-6100maxit = 100101

102best_path = None103for it in range(maxit):104 c0_mid = 0.5 * (c0_low + c0_high)105 path = simulate_path(c0_mid, T=T, k0=k0)106

107 if not path["feasible"]:108 # too much consumption early (or bad dynamics) -> lower c0109 c0_high = c0_mid110 continue111

112 k_T = path["k"][-1]113 # If terminal capital is above target, we consumed too little (c0 can be higher)114 if k_T > target:115 c0_low = c0_mid116 best_path = path117 else:118 c0_high = c0_mid119 best_path = path120

121 if abs(k_T - target) < tol:122 break123

124if best_path is None or not best_path["feasible"]:125 raise RuntimeError("Bisection failed to find a feasible path. Try different bounds or T/k0.")126

127# -----------------------------128# 5) Report & plots129# -----------------------------130print("=== Ramsey Model Solution ===")131print(f"Parameters: A={A}, α={alpha}, δ={delta}, β={beta}, θ={theta}")132print(f"Steady state: k*={k_star:.6f}, c*={c_star:.6f}, y*={y_star:.6f}, i*={i_star:.6f}")133print(f"Initial k0={k0:.6f}, solved c0={best_path['c'][0]:.6f}")134print(f"Terminal k_T={best_path['k'][-1]:.6f} (target k*={k_star:.6f})")135

136t = np.arange(T+1)137

138plt.figure()139plt.plot(t, best_path["k"], label="Capital k_t")140plt.axhline(k_star, linestyle="--", label="k*")141plt.xlabel("t"); plt.ylabel("k")142plt.title("Capital Path")143plt.legend()144plt.show()145

146plt.figure()147plt.plot(t, best_path["c"], label="Consumption c_t")148plt.axhline(c_star, linestyle="--", label="c*")149plt.xlabel("t"); plt.ylabel("c")150plt.title("Consumption Path")151plt.legend()152plt.show()153

154plt.figure()155plt.plot(t, best_path["y"], label="Output y_t")156plt.axhline(y_star, linestyle="--", label="y*")157plt.xlabel("t"); plt.ylabel("y")158plt.title("Output Path")159plt.legend()160plt.show()161

162plt.figure()163plt.plot(t, best_path["i"], label="Investment i_t")164plt.axhline(i_star, linestyle="--", label="i*")165plt.xlabel("t"); plt.ylabel("i")166plt.title("Investment Path")167plt.legend()168plt.show()นอกจากนี้ LLMs พอจะช่วยงานด้านคณิตศาสตร์ได้ในระดับหนึ่ง แต่ก็ยังมีข้อจำกัด เนื่องจากข้อมูลที่ใช้ฝึกส่วนใหญ่เป็นข้อความทั่วไปมากกว่าข้อมูลเชิงคณิตศาสตร์ LLMs สามารถช่วยตั้งสมการของแบบจำลอง แก้สมการเพื่อหา solution หรือ steady state และอธิบายแบบจำลองเชิงทฤษฎีได้ (Korinek, 2024) รูปที่ 4 แสดงตัวอย่างกรณีให้ GPT-5 ช่วยเขียนสมการแสดง consumer optimization problem โดยเขียนในรูปแบบ LaTeX และแก้สมการเพื่อหา demand function พร้อมทั้งอธิบายขั้นตอนการแก้ปัญหา

Set up the optimization problem of a consumer with CES preferences over two goods, in LaTeX code.

Here's a clean LaTeX setup for a standard consumer optimization problem with CES preferences over two goods , :

1\documentclass{article}2\usepackage{amsmath, amssymb}3

4\begin{document}5

6\section*{Consumer Problem with CES Preferences}7

8Consider a consumer with CES utility over two goods \(x_1, x_2\):9

10\[11U(x_1, x_2) = \left[ \alpha x_1^{\rho} + (1-\alpha)x_2^{\rho} \right]^{\frac{1}{\rho}},12\]13

14where \(0 < \alpha < 1\) and \(\rho \leq 1, \rho \neq 0\) is the substitution parameter.15

16\noindent The consumer faces prices \(p_1, p_2 > 0\) and income \(I > 0\). 17The optimization problem is:18

19\[20\begin{aligned}21\max_{x_1, x_2 \geq 0} \quad & \left[ \alpha x_1^{\rho} + (1-\alpha)x_2^{\rho} \right]^{\frac{1}{\rho}} \\22\text{s.t.} \quad & p_1 x_1 + p_2 x_2 = I.23\end{aligned}24\]25

26\noindent The Lagrangian for this problem is:27

28\[29\mathcal{L} = 30\left[ \alpha x_1^{\rho} + (1-\alpha)x_2^{\rho} \right]^{\frac{1}{\rho}}31+ \lambda \bigl( I - p_1 x_1 - p_2 x_2 \bigr).32\]33

34First-order conditions (FOCs):35

36\[37\frac{\partial \mathcal{L}}{\partial x_1} = 38\left[ \alpha x_1^{\rho} + (1-\alpha)x_2^{\rho} \right]^{\frac{1}{\rho}-1} 39\alpha x_1^{\rho-1} - \lambda p_1 = 0,40\]41

42\[43\frac{\partial \mathcal{L}}{\partial x_2} = 44\left[ \alpha x_1^{\rho} + (1-\alpha)x_2^{\rho} \right]^{\frac{1}{\rho}-1} 45(1-\alpha) x_2^{\rho-1} - \lambda p_2 = 0,46\]47

48\[49\frac{\partial \mathcal{L}}{\partial \lambda} = I - p_1 x_1 - p_2 x_2 = 0.50\]51

52\end{document}GenAI สามารถช่วยให้กระบวนการสื่อสารงานวิจัยรวดเร็วและมีประสิทธิภาพมากขึ้น โดยเฉพาะการเขียน GenAI สามารถสร้างเนื้อหาใหม่จาก bullet points ช่วยปรับน้ำเสียงและวิธีการเขียนให้เหมาะกับผู้อ่านแต่ละกลุ่ม ไม่ว่าจะเป็นการเขียนบทความวิชาการ บทความเชิงบรรณาธิการ (op-ed) เขียนบทสรุปสำหรับสื่อสังคมออนไลน์ สามารถตรวจสอบภาษา และสรุปเอกสารยาวให้กระชับขึ้น รวมทั้งสามารถทำสคริปต์สำหรับ podcast หรือทำ podcast ได้

ในการใช้งานจริง European Central Bank ได้ใช้ GenAI ในการช่วยแปลภาษาเพื่อให้การสื่อสารระหว่างประเทศที่ใช้ภาษาต่างกันกว่า 24 ภาษา และธนาคารกลางประเทศเยอรมันก็ได้นำ AI มาวิจารณ์ข้อความที่สื่อสารกับสาธารณะ และช่วยปรับภาษาเพื่อให้การสื่อสารมีประสิทธิภาพขึ้น (Kazinnik & Brynjolfsson, 2025)

นอกจากนี้ LLMs ยังสามารถแปลงข้อความให้อยู่ในรูปแบบที่ต้องการ ไม่ว่าจะเป็น LaTeX, Markdown หรือ HTML หรือแปลงข้อมูล excel เป็นตารางในรูปแบบ LaTeX ทั้งนี้ แบบจำลองอย่างเช่น GPT ก็ไม่ได้ถนัดทุกอย่าง

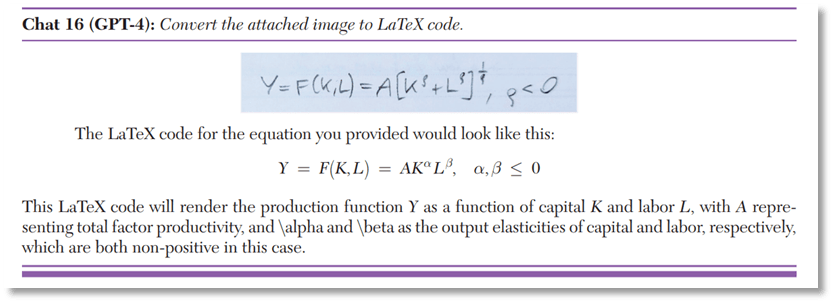

ในรูปที่ 5 เป็นตัวอย่างจาก Korinek (2024) ที่ให้ GPT-4 แปลงสมการจากลายมือเขียนเป็น LaTex ผลพบว่า GPT-4 ไม่ได้ใส่วงเล็บและแปลง CES function ให้กลายเป็น Cobb-Douglas function ไปแทน ผู้ใช้จึงควรต้องมีการตรวจสอบอย่างรอบคอบ

อย่างไรก็ดี งานลักษณะดังกล่าว GenAI บางตัว เช่น MathPix.com ที่ถูกฝึกมาด้านนี้โดยเฉพาะน่าจะทำได้ดีกว่าแบบจำลองอื่น ๆ ส่วน o1-series หรือ Wolfram GPT ก็มีความสามารถด้านคณิตศาสตร์ที่เด่น หรือ Github Copilot, Claude 3.5 ที่ถูกพัฒนามาเพื่อช่วยในการเขียนโค้ด โดย Korinek (2024) แสดงรายละเอียดของความสามารถโดยเฉพาะของแบบจำลองต่าง ๆ

นักวิจัยเริ่มมีการทดลองให้ GenAI เป็นคนกลุ่มต่าง ๆ (synthetic agents) เพื่อทดลองว่าจะมีพฤติกรรมอย่างไร Horton (2023) เห็นว่า GenAI เป็น computational models of humans และถูกฝึกมาจากข้อมูลมหาศาลที่ครอบคลุมทั้งกฎหมาย ทัศนคติของผู้คนในสังคม และการตัดสินใจจากสิ่งที่คุ้นเคย จึงสามารถจำลองพฤติกรรมของคนที่หลากหลายและใกล้เคียงกับความเป็นจริงมากขึ้น และนักวิจัยสามารถใช้ GenAI agents มาทดสอบการทดลองนำร่องได้ด้วยต้นทุนที่ต่ำ ใช้เวลาไม่นาน และทดสอบสมมติฐานได้ ก่อนที่จะไปทดลองกับกลุ่มตัวอย่างที่เป็นคนจริง ๆ รวมถึงนักวิจัยอาจจะได้มุมมองเพิ่มเติมอีกด้วย

Horton (2023) ได้ทดลองให้ GenAI agent เล่นเกมใน classic experiments ของเศรษฐศาสตร์พฤติกรรม ซึ่งได้ผลใกล้เคียงกับข้อค้นพบที่เคยมี เช่น GenAI ก็มี status quo bias เหมือนมนุษย์ และอีกหนึ่งตัวอย่างทดลองให้ GenAI agent เล่นบทบาทเป็นผู้จัดการร้านอาหาร และให้มีการเพิ่มค่าแรงขั้นต่ำ ผลพบว่าผู้จัดการที่สร้างขึ้นมาเลือกที่จะจ้างผู้สมัครที่มีประสบการณ์มากขึ้น สอดคล้องกับผลการศึกษาเชิงประจักษ์ในอดีต งานของ Hansen et al. (2024) ลองให้ GenAI agent เป็น professional forecasters โดยให้ข้อมูล profile ของคนกลุ่มนี้ ให้ข้อมูลเศรษฐกิจต่าง ๆ และให้ตอบคำถามใน Survey of Professional Forecasters4 พบว่า agents เหล่านี้ก็พยากรณ์ได้ใกล้เคียงกับผู้เชี่ยวชาญและจริง ๆ ทำได้ดีกว่าสำหรับการพยากรณ์ในระยะกลางและระยะยาว โดยงานนี้ใช้ GPT-4o-mini เป็นหลัก งานของ Faria-e Castro & Leibovici (2024) ก็ได้ข้อค้นพบที่ใกล้เคียงกัน โดยได้ prompt ให้ PaLM ของ Google พยากรณ์อัตราเงินเฟ้อ CPI ของสหรัฐฯ ระหว่างปี 2019–2023 และพบว่าได้ผลแม่นยำกว่า Survey of Professional Forecasters อย่างไรก็ดี การใช้ LLMs เพื่อการพยากรณ์ยังคงมีข้อกังขาในเชิงวิชาการ โดยเฉพาะประเด็น ความเป็น “กล่องดำ” ของแบบจำลอง และข้อจำกัดในการตรวจสอบ ที่มาของข้อมูลฝึก ที่ไม่สามารถตรวจสอบได้ชัดเจนว่าเป็นการทดสอบแบบ out-of-sample จริงหรือไม่

Argyle et al. (2023) เสนอแนวคิด silicon sampling โดยสร้างประชากรจำลองด้วย GenAI agents ที่มีประวัติพื้นฐานของผู้ตอบแบบสอบถามจริง และให้แบบจำลองตอบคำถามทัศนคติของกลุ่มประชากรย่อยที่สนใจ งานนี้ใช้ข้อมูล American National Election Studies (ANES) ซึ่งมีประวัติของผู้ตอบแบบสอบถามจริงหลายพันคนมาสร้างประชากรจำลอง พบว่าผลคะแนนเลือกตั้งของ silicon samples ในปี 2012, 2016 และ 2020 สอดคล้องกับข้อมูลจริงสูงมาก (correlation 0.9–0.94) Argyle et al. (2023) มองว่าอีกประโยชน์ของ silicon sampling คือ การที่นักวิจัยสามารถใช้ GenAI ทดสอบตอบแบบสอบถามล่วงหน้าเพื่อดูว่าผู้ตอบแต่ละกลุ่มจะเข้าใจและตอบคำถามอย่างไร

GenAI มีพัฒนาการมากในช่วง 2–3 ปีที่ผ่านมา และสามารถเป็น “ผู้ช่วยวิจัย” ที่นักวิจัยสามารถขอความช่วยเหลือได้รวดเร็วและต้นทุนไม่สูงนัก อย่างไรก็ดี ดังเช่นผู้ช่วยวิจัยที่เป็นคน ผลลัพธ์ก็ยังมีความผิดพลาดได้ ซึ่งอาจจะมาจากการที่ GenAI ไม่เข้าใจคำสั่งดีพอ ไม่ได้ถูกฝึกมาในบริบทที่นักวิจัยสนใจ มีอคติ หรือแต่งเนื้อหาหรือสร้าง stereotype ขึ้นมาเอง (hallucination) ทั้งนี้เพราะกระบวนการฝึกและประเมินผล GenAI ที่ผ่านมามักให้รางวัลกับการ เดา มากกว่าการยอมรับว่าไม่รู้ (Kalai et al., 2025) นักวิจัยเองยังจำเป็นต้องตรวจสอบความถูกต้องของเนื้อหาและตรรกะของทุกขั้นตอนอย่างรอบคอบ นอกจากนี้ เพื่อความโปร่งใส Chang et al. (2024) ได้แนะนำด้วยว่านักวิจัยควรรายงานด้วยว่ามีการใช้ GenAI ในกระบวนการใดบ้าง ใช้ prompt อย่างไร เพื่อให้สามารถทำซ้ำได้ (reproducibility) และต้องคำนึงถึงเรื่องความปลอดภัยของข้อมูลในการใช้ API สาธารณะด้วย

งานด้าน GenAI มีความก้าวหน้าอย่างรวดเร็ว ข้อจำกัดที่เราพูดถึงในบทความนี้ อาจจะได้รับการแก้ไขในอนาคต แต่ขณะเดียวกันก็อาจจะมีข้อควรระวังใหม่ ๆ ที่เพิ่มขึ้นมา ดังนั้น แม้ GenAI จะเป็นผู้ช่วยวิจัยที่ดีและต้นทุนต่ำ นักวิจัยก็ต้องเรียนรู้ “นิสัย” และ “ความสามารถ” ของผู้ช่วยวิจัยตัวนี้ เพื่อจะได้ปรับตัว เพิ่มประสิทธิภาพในกระบวนการทำงาน และลดความเสี่ยงจากข้อผิดพลาด

เอกสารอ้างอิง

- แบบจำลอง DL อีกหลายตัวถูกประดิษฐ์ขึ้นสำหรับงานประเภทต่าง ๆ เช่น Feedforward Neural Network สำหรับปัญหาง่าย ๆ เช่น การแยก spam email, Convolutional Neural Network สำหรับการเรียนรู้ภาพ และ Recurrent Neural Network และ Long-Short Term Memory ซึ่งมีความจำเกี่ยวกับ input ก่อนหน้า ทำให้สามารถประมวลผลภาษา และพยากรณ์ข้อมูล time-series ได้ดี↩

- ดูเพิ่มเติมใน PIER blog Generative AI: ถึงเวลาที่แรงงานทักษะสูงจะต้องปรับตัว และ Bank for International Settlements (2024)↩

- O*NET OnLine ตัวอย่างเช่น ลักษณะงานของอาชีพนักเศรษฐศาสตร์ ได้แก่ study economic and statistical data in area of specialization; compile, analyze, and report data; study the socioeconomic impacts of new public policies↩

- Survey of Professional forecasters by Federal Reserve Bank of Phildadelphia↩